Scalability Testing for API Gateways Under High Traffic

Tests de scalabilité pour les passerelles API sous un trafic élevé sont conçus pour simuler des milliers d'utilisateurs virtuels provenant de plus de 26 régions cloud, garantissant que votre passerelle API peut gérer un trafic à grande échelle et à fort volume sans dégrader les performances. Ce modèle fournit une approche structurée pour tester la scalabilité de votre API, vous aidant à identifier les goulets d'étranglement, à améliorer le débit et à garantir que votre passerelle fonctionne efficacement sous une charge maximale.

Qu'est-ce que le test de scalabilité pour les passerelles API ?

Le test de scalabilité pour les passerelles API se concentre sur l'évaluation de la capacité de votre passerelle API à gérer des niveaux de trafic croissants sans affecter les performances. Ce modèle vous permet de simuler de fortes augmentations de trafic et des conditions de charge élevée continues pour évaluer comment votre infrastructure API se développe. En tirant parti d'un outil puissant comme LoadFocus (Service de test de charge LoadFocus), vous pouvez exécuter des tests avec des milliers d'utilisateurs virtuels concurrents provenant de plus de 26 régions cloud, garantissant que votre passerelle API reste fiable et réactive pendant les périodes de forte demande.

Ce modèle vous aide à concevoir, exécuter et analyser des tests de scalabilité pour votre passerelle API, garantissant qu'elle peut évoluer efficacement et fournir un service ininterrompu même pendant les charges de pointe.

Comment ce modèle aide-t-il ?

Notre modèle vous guide dans la configuration et l'exécution de tests de scalabilité pour votre passerelle API. Il offre des meilleures pratiques pour découvrir les goulets d'étranglement de performance, améliorer le débit et optimiser l'allocation des ressources de la passerelle API, garantissant que votre infrastructure est prête pour un trafic à fort volume.

Pourquoi avons-nous besoin de tests de scalabilité pour les passerelles API ?

Sans tests de scalabilité, votre passerelle API pourrait rencontrer des ralentissements, des erreurs, voire des temps d'arrêt pendant les périodes de fort trafic. Ce modèle vous aide à garantir que votre passerelle peut gérer de grands volumes de demandes, permettant un fonctionnement fluide même lorsque la demande augmente.

- Identifier les goulets d'étranglement : Identifier les contraintes de ressources, telles qu'une capacité serveur limitée ou des temps de traitement lents, qui affectent la scalabilité.

- Optimiser les performances : Affiner les configurations serveur et optimiser le code pour gérer plus de demandes sans sacrifier les performances.

- Assurer la fiabilité : Une passerelle API évolutive garantit disponibilité et réactivité, même lorsque le trafic augmente de manière inattendue.

Comment fonctionne le test de scalabilité pour les passerelles API

Ce modèle couvre une variété de techniques de test conçues pour évaluer les performances de votre passerelle API sous charge. En utilisant les outils LoadFocus, vous pouvez configurer des tests qui simulent différents modèles de trafic et mesurent le débit, les temps de réponse, les taux d'erreur et l'utilisation des ressources système.

Les bases de ce modèle

Le modèle fournit des scénarios de test prédéfinis, des métriques de performance et des critères de succès, que vous pouvez utiliser pour configurer des tests de scalabilité pour votre passerelle API. LoadFocus s'intègre à votre infrastructure existante pour offrir des tableaux de bord de performance en temps réel et des informations tout au long de votre processus de test.

Composants clés

1. Conception de scénarios

Définir différents scénarios de charge basés sur des modèles de trafic réels, y compris des pics de demandes, un trafic constant et des pics de trafic soudains.

2. Simulation d'utilisateurs virtuels

Le modèle vous aide à configurer des tests avec des milliers d'utilisateurs virtuels concurrents. Avec LoadFocus, vous pouvez facilement faire évoluer vos tests pour simuler des scénarios de trafic attendus ou dans le pire des cas.

3. Suivi des métriques de performance

Suivez les métriques de performance clés telles que le débit, la latence, les taux d'erreur et l'utilisation des ressources serveur pour évaluer comment votre passerelle API gère un trafic élevé.

4. Alertes et notifications

Apprenez à configurer des notifications par e-mail, SMS ou Slack pour des alertes immédiates lorsque les seuils de performance sont dépassés.

5. Analyse des résultats

Une fois le test terminé, le modèle explique comment analyser les rapports LoadFocus pour identifier les goulets d'étranglement et optimiser votre passerelle API.

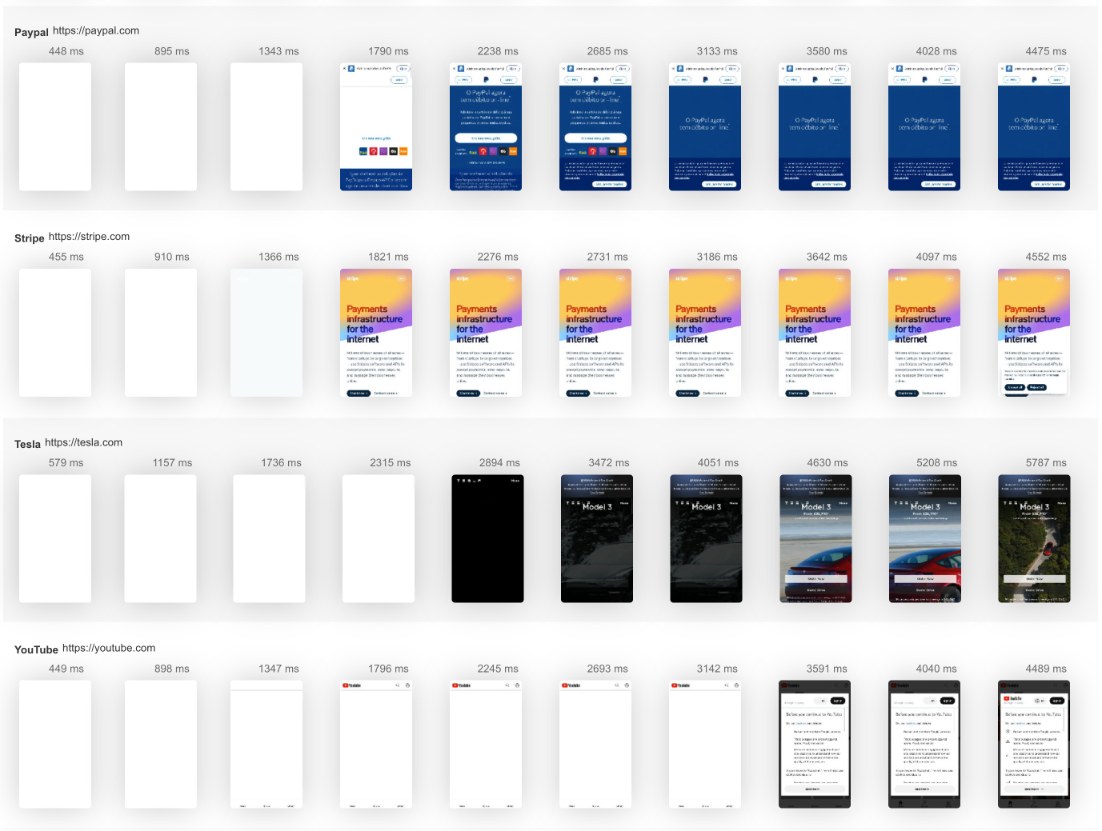

Visualisation des tests de scalabilité

Imaginez votre passerelle API gérant des milliers de demandes simultanément. Le modèle illustre comment les visualisations LoadFocus suivent les baisses de performance, les pics d'erreurs et la santé du système, vous aidant à prendre des décisions basées sur les données pour améliorer la scalabilité.

Quels types de tests de scalabilité existe-t-il ?

Ce modèle comprend plusieurs méthodes de test de scalabilité pour garantir que votre passerelle API peut gérer un trafic élevé :

Tests de stress

Poussez votre passerelle API à ses limites en simulant des niveaux de trafic élevés et en identifiant la capacité maximale qu'elle peut gérer.

Tests de pics

Simulez des pics de trafic soudains (par exemple, des campagnes marketing ou des événements viraux) pour voir comment la passerelle gère les augmentations de trafic.

Tests d'endurance

Testez la capacité de votre passerelle API à soutenir des niveaux de trafic élevés sur de longues périodes sans dégradation des performances.

Tests de scalabilité

Augmentez progressivement le trafic pour voir comment votre passerelle API évolue et pour identifier les contraintes de ressources dès le départ.

Tests de volume

Testez la capacité de votre passerelle API à gérer de grands volumes de demandes de données, garantissant qu'elle peut gérer des charges lourdes sans ralentir.

Cadres de test de charge pour les passerelles API

Bien que des outils comme JMeter ou Gatling puissent être utilisés pour les tests de scalabilité, LoadFocus excelle dans la simplification du processus de test avec une génération de charge basée sur le cloud automatisée, un suivi en temps réel et des rapports détaillés, vous offrant une image précise de la façon dont votre passerelle API se comportera sous un trafic élevé.

Surveillance de vos tests de scalabilité

La surveillance en temps réel est essentielle pour comprendre l'impact du trafic sur votre passerelle API. LoadFocus fournit des tableaux de bord en direct où vous pouvez suivre des métriques telles que le débit, les temps de réponse et les taux d'erreur en temps réel, vous permettant de résoudre les problèmes au fur et à mesure qu'ils surviennent.

L'importance de ce modèle pour les performances de votre passerelle API

Ce modèle aide à garantir que votre passerelle API peut gérer les exigences d'un trafic à fort volume. En identifiant les problèmes de scalabilité et en optimisant les performances, vous pouvez améliorer la fiabilité de votre passerelle et éviter les temps d'arrêt pendant les pics de trafic.

Métriques critiques à suivre

- Débit : Surveillez le taux de demandes traitées par votre passerelle API par seconde.

- Temps de réponse : Suivez la rapidité avec laquelle la passerelle répond aux demandes pendant les tests de charge.

- Taux d'erreur : Mesurez le nombre de demandes échouées pendant les tests pour identifier les goulets d'étranglement de performance.

- Utilisation des ressources : Suivez l'utilisation des ressources serveur (CPU, mémoire, réseau) pour garantir que la passerelle a suffisamment de capacité pour évoluer.

Quelles sont les meilleures pratiques pour ce modèle ?

- Simuler un trafic réel : Créez des tests qui reflètent des modèles d'utilisation réels, tels que des taux de demande variables ou de grandes charges de données.

- Effectuer des tests de scalabilité périodiques : Planifiez des tests régulièrement, surtout avant les lancements de produits, pour garantir que votre passerelle API peut gérer une charge accrue.

- Automatiser les tests : Mettez en place des tests automatisés qui s'exécutent en continu pour identifier les problèmes tôt dans le cycle de développement.

- Intégrer avec CI/CD : Incorporez les tests de scalabilité dans votre pipeline d'intégration continue pour garantir que les performances ne se dégradent pas avec chaque nouvelle version.

Avantages de l'utilisation de ce modèle

Détection précoce des problèmes

Identifiez les goulets d'étranglement de performance et les points de défaillance avant qu'ils n'affectent les utilisateurs pendant les périodes de fort trafic.

Performance optimisée de la passerelle API

Affinez les configurations de la passerelle API pour gérer plus de demandes, réduire la latence et améliorer la réactivité globale.

Fiabilité améliorée

Assurez-vous que votre passerelle API reste stable, même pendant des pics de trafic inattendus ou des périodes à fort volume.

Infrastructure évolutive

Préparez votre infrastructure à gérer la croissance future, facilitant l'évolutivité à mesure que la demande des utilisateurs augmente.

Alertes en temps réel

Restez proactif et résolvez les problèmes de scalabilité en temps réel avec des notifications immédiates de LoadFocus.

Tests de scalabilité continus - Le besoin constant

Ce modèle souligne l'importance des tests de scalabilité continus à mesure que votre passerelle API évolue. Des tests réguliers aident à garantir que votre passerelle API peut gérer les demandes croissantes de trafic à mesure que votre entreprise se développe.

Performance cohérente

Effectuez des tests réguliers pour garantir que votre passerelle API maintient de hautes performances pendant les périodes de trafic de pointe.

Résolution proactive des problèmes

Résolvez les problèmes de scalabilité avant qu'ils n'affectent les utilisateurs, minimisant les temps d'arrêt et prévenant les perturbations potentielles.

Adaptation à la croissance

À mesure que votre base d'utilisateurs croît, faites évoluer vos tests pour correspondre à la demande croissante et garantir que votre passerelle API reste efficace.

Analyse des performances à long terme

Suivez les performances au fil du temps pour voir comment votre passerelle API réagit à des volumes de trafic croissants et identifier les domaines à optimiser.

Cas d'utilisation des tests de scalabilité des passerelles API

Ce modèle est idéal pour tester les passerelles API dans divers secteurs nécessitant une gestion de trafic élevé :

Applications mobiles

- Événements de trafic de pointe : Simulez des pics de trafic provenant d'utilisateurs mobiles, garantissant que la passerelle API peut gérer des pics de demandes.

- Mises à jour en temps réel : Testez la capacité à gérer des envois de données en temps réel, tels que des notifications ou des mises à jour en direct.

Services basés sur le cloud

- Utilisateurs concurrents élevés : Assurez-vous que votre passerelle API cloud peut gérer plusieurs demandes d'utilisateurs simultanément sans erreurs.

- Scalabilité dynamique : Testez la capacité de votre passerelle API à évoluer automatiquement en fonction de la charge utilisateur.

Plateformes de commerce électronique

- Listes de produits lourdes : Testez les performances des appels API qui gèrent de grands catalogues ou des données utilisateur.

- Inventaire en temps réel : Testez la capacité à gérer des mises à jour d'inventaire en temps réel pendant les événements de vente.

Services financiers

- Traitement des transactions : Assurez-vous que votre passerelle API peut gérer de grands volumes de transactions financières avec une faible latence.

- Sécurité et conformité : Testez la sécurité de votre passerelle API lors du traitement de données financières sensibles.

Services de streaming vidéo

- Streams concurrents élevés : Testez comment votre passerelle API se comporte pendant des événements de streaming vidéo avec de nombreux spectateurs simultanés.

- Faible latence : Assurez-vous que les réponses API ont une faible latence pendant la lecture vidéo ou les demandes de contenu.

Défis courants des tests de scalabilité des passerelles API

Ce modèle décrit comment aborder les défis courants rencontrés lors des tests de scalabilité pour les passerelles API.

Gestion de la charge accrue

- Tester au-delà des limites : Assurez-vous que votre passerelle API peut évoluer au-delà de la charge actuelle pour gérer de futurs pics de trafic.

- Allocation optimale des ressources : Assurez-vous que votre infrastructure dispose de suffisamment de ressources pour gérer la charge accrue efficacement sans dégradation des performances.

Variance des données

- Données de test cohérentes : Assurez-vous que les données de test sont réalistes, telles que des types de demandes variés et des tailles de charge utiles, pour refléter l'utilisation réelle.

- Rapports précis : Collectez des métriques fiables pour évaluer avec précision les performances de votre passerelle API.

Efficacité des tests

- Réduction du temps de test : Équilibrez la couverture complète des tests et le besoin d'un temps d'exécution de test efficace.

- Tests évolutifs : Augmentez progressivement la charge de test pour évaluer comment la passerelle API évolue et quelles limites elle peut atteindre.

Sécurité

- Protection des données sensibles : Assurez-vous que toutes les données et le trafic de la passerelle API sont traités de manière sécurisée pendant les tests.

- Conformité : Testez la capacité de votre passerelle API à gérer des données sensibles en conformité avec les normes de sécurité.

Flexibilité et personnalisation

- Scénarios de test sur mesure : Personnalisez les tests en fonction de vos cas d'utilisation API spécifiques et des modèles de trafic.

- Adaptation : Adaptez les tests de scalabilité à mesure que votre plateforme évolue, en intégrant de nouvelles API ou fonctionnalités utilisateur.

Collaboration d'équipe

- Partage des informations : Collaborez avec vos équipes de développement, QA et DevOps pour analyser les résultats des tests et optimiser les performances de la passerelle API.

- Alignement entre les équipes : Assurez-vous que toutes les équipes comprennent les objectifs de scalabilité et les métriques de performance pendant les tests.

Commencer avec ce modèle

Suivez ces étapes simples pour tirer le meilleur parti de ce modèle de test de scalabilité des passerelles API :

- Cloner ou importer le modèle : Chargez-le dans votre projet LoadFocus pour une configuration facile.

- Cartographier les scénarios de trafic : Définissez des modèles de trafic tels que des charges de pic, un trafic constant et un trafic élevé soutenu.

- Définir les niveaux de charge : Définissez le nombre d'utilisateurs virtuels, la durée de la charge et les régions pour les tests.

Comment configurer les tests de scalabilité des passerelles API

Configurer des tests de scalabilité est facile avec LoadFocus :

- Définir les paramètres de test : Choisissez votre(s) région(s) cloud, le temps de montée en charge et le nombre total d'utilisateurs.

- Configurer les points de terminaison API : Configurez des points de terminaison API spécifiques à tester sous différents scénarios de charge.

- Surveiller les résultats : Utilisez des tableaux de bord en temps réel pour suivre des métriques clés telles que le débit, la latence et les taux d'erreur.

Pourquoi utiliser LoadFocus avec ce modèle ?

LoadFocus simplifie la création de tests, l'évolutivité et les rapports, offrant :

- Plusieurs régions cloud : Testez depuis plus de 26 régions cloud pour une vue de performance réaliste à travers les géographies.

- Scalabilité : Simulez facilement des milliers d'utilisateurs virtuels pour tester la capacité de gestion de votre passerelle API.

- Analytique détaillée : Obtenez des informations sur les temps de réponse, les taux d'erreur et l'utilisation des ressources serveur.

- Intégration facile : Intégrez les tests de scalabilité dans votre pipeline d'intégration continue pour une validation régulière des performances.

Pensées finales

Ce modèle vous permet d'évaluer et d'optimiser la scalabilité de votre passerelle API, garantissant qu'elle reste performante et fiable dans des conditions de trafic élevé. En combinant les étapes décrites ici avec LoadFocus Load Testing, vous pouvez garantir des expériences utilisateur fluides pendant les périodes de forte demande.

FAQ sur les tests de scalabilité des passerelles API

Quel est l'objectif des tests de scalabilité pour les passerelles API ?

L'objectif est de garantir que votre passerelle API peut gérer des niveaux croissants de trafic sans dégradation des performances ou temps d'arrêt.

En quoi ce modèle est-il différent des autres modèles de test de charge ?

Ce modèle se concentre spécifiquement sur les performances des passerelles API dans des conditions de fort trafic, vous aidant à évaluer la scalabilité et à optimiser votre passerelle en conséquence.

Puis-je personnaliser ce modèle pour mon API ?

Oui, le modèle peut être adapté pour tester des points de terminaison API spécifiques et des modèles de trafic utilisateur uniques à votre passerelle API.

À quelle fréquence devrais-je utiliser ce modèle ?

Nous recommandons d'effectuer des tests de scalabilité régulièrement, surtout avant des versions majeures ou des augmentations de trafic.

Ai-je besoin d'un environnement de test dédié ?

Bien qu'il soit idéal d'exécuter des tests dans un environnement dédié, vous pouvez également exécuter des tests de scalabilité en production avec les mesures de sécurité appropriées en place.

Puis-je tester le trafic API mobile ?

Oui. Vous pouvez simuler le trafic des appareils mobiles et tester comment votre passerelle API gère les demandes spécifiques aux mobiles.

```Quelle est la vitesse de votre site web?

Augmentez sa vitesse et son référencement naturel de manière transparente avec notre Test de Vitesse gratuit.Vous méritez de meilleurs services de test

Donnez du pouvoir à votre expérience numérique ! Plateforme cloud complète et conviviale pour le test et le monitoring de charge et de vitesse.Commencez à tester maintenant→